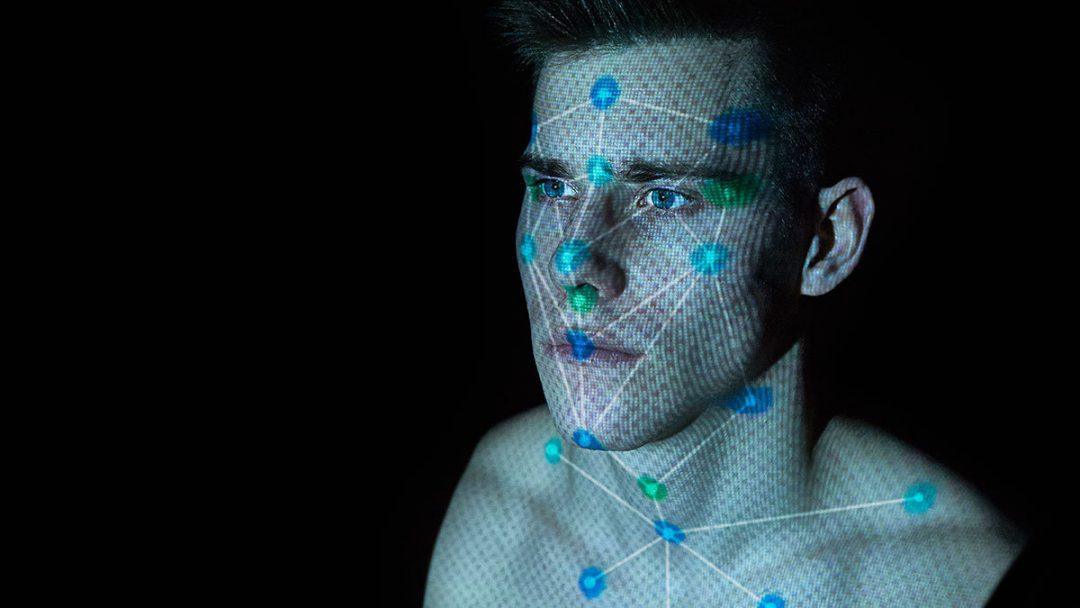

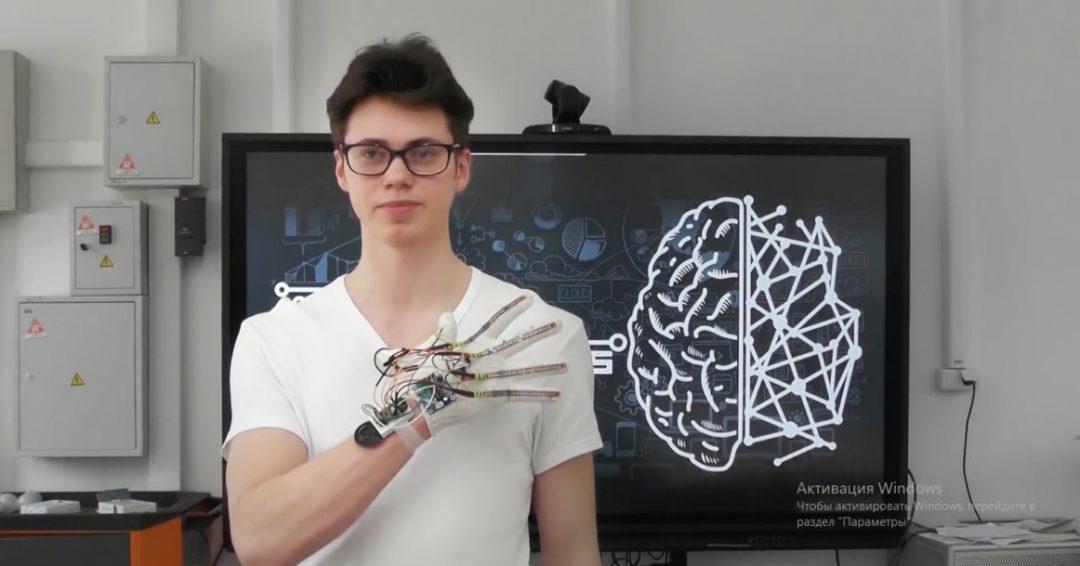

🤔 Что случилось: YouTube заблокировал популярный канал шахматиста из Хорватии за опасное и вредоносное содержимое.

Исследователи предположили, что это произошло из-за движения Black Lives Matter. Они проверили работу алгоритмов определения языка вражды почти на 700 тыс. комментариев в шахматных YouTube-каналах и выяснили, что 82% отобранных нейронками сообщений не содержало слов расовой ненависти. Алгоритмы реагировали на такие слова, как «белые», «чёрные», «атака», «угроза» и так далее.

🤨 И что? YouTube использует для анализа контента машинные алгоритмы, а значит, любой аккаунт может быть заблокирован за подобную речь. Если вашей белой стене угрожает чёрная плесень, этот контент может тоже оказаться неприемлемым.

Хорошо, что это пока мало касается русскоязычной аудитории.

👥 Кто: студенты Университета Карнеги — Меллона.

Источник: Tech Xplore

![[Вот, почитайте] Как устроен Умный город в Москве](https://thecode.media/wp-content/uploads/2020/04/111704288_ae543cb6-e126-4e64-9b0f-b4b874131338.jpg)