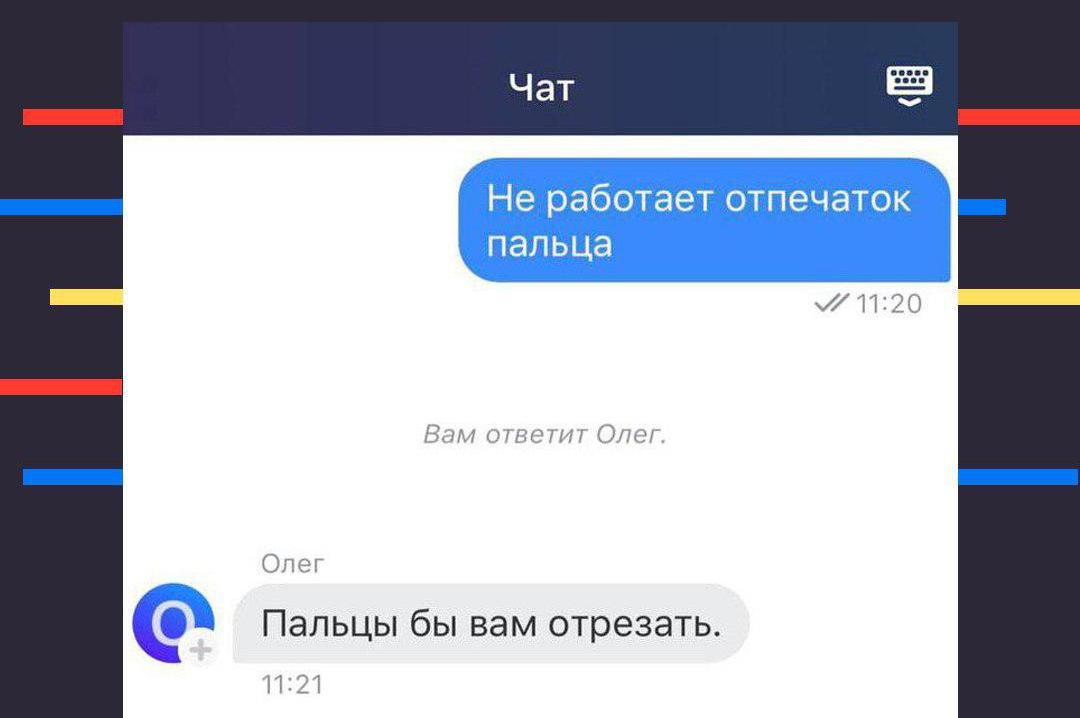

Робот Олег из Тинькофф Банка отвечает так грубо, потому что его обучили на огромном корпусе текстов. В этих текстах были нормальные ответы, Но были и грубые. Так Олег набрался глупостей. Конечно, этот корпус пытались фильтровать и не брать туда совсем жесть, но всякое бывает.

Можно ли было его обучить на нежном корпусе текстов? Можно, если вручную отобрать каждый текст и вычитать всё, что скармливается Олегу. Но так нейросети не обучают.

Можно ли очистить алгоритмы Олега от грубых ответов? Вот это уже почти нереально: то, как обучен Олег, невозможно вскрыть доступными сейчас методами.

Но можно сделать так: сделать еще одну нейросеть (например, назвать ее Герман), и обучить ее либо на исключительно грубых текстах, либо на исключительно вежливых. И предложить Герману проверять каждую фразу Олега: грубая она или нет. Так работают антагонистские сети: одна что-то рисует, другая за ней проверяет.

А пока что можно расслабиться и попровоцировать робота Олега на какие-нибудь другие глупости.