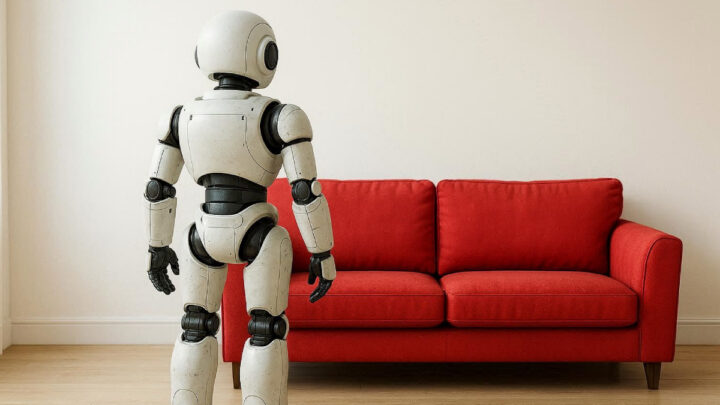

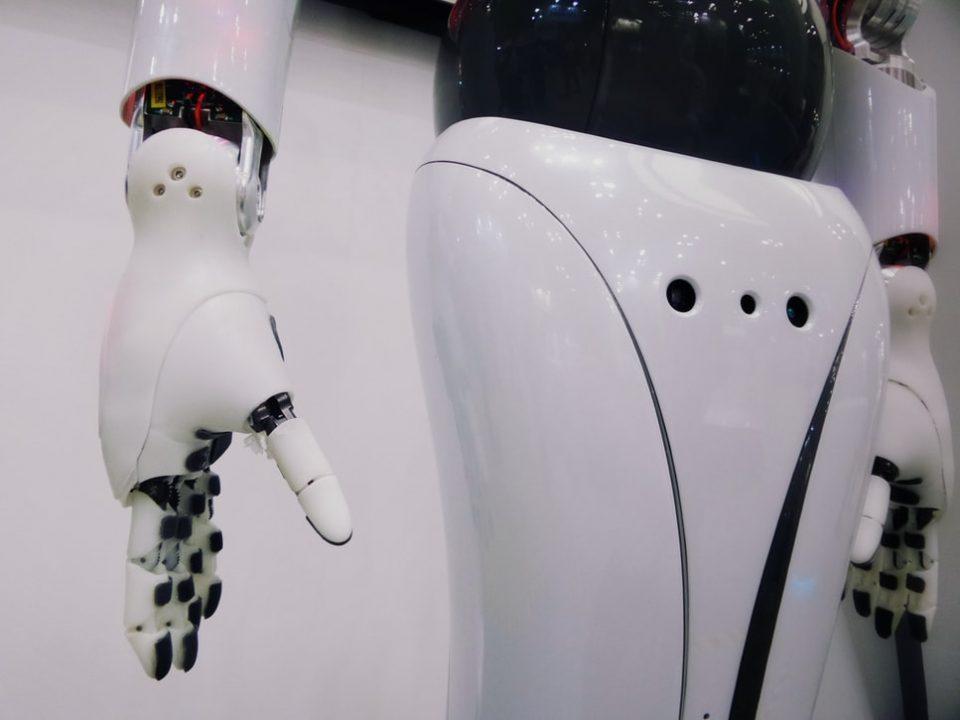

Группа исследователей из Чунцинского университета (Китай) разработала IVLMap — AI-систему, которая позволяет роботам лучше ориентироваться в помещениях и выполнять команды на обычном языке. Раньше роботу нужно было говорить: «Переместись на X=5, Y=3, поверни на 90°». Теперь достаточно: «Найди красный диван в гостиной» — и робот сам разберётся, сообщает HackerNoon.

IVLMap создаёт визуально-семантические карты: система различает конкретные объекты, а не просто категории. Интеграция с Llama 2 позволяет обрабатывать сложные команды как в симуляторах, так и в реальном мире.

Это часть тренда spatial intelligence — пространственного интеллекта, который является ключом к появлению роботов нового поколения. Традиционные системы навигации (GPS, внешние датчики, сложные сенсоры) не работают в помещениях, под землёй или в постоянно меняющихся условиях. Системы вроде IVLMap решают эту проблему через зрение и понимание языка.

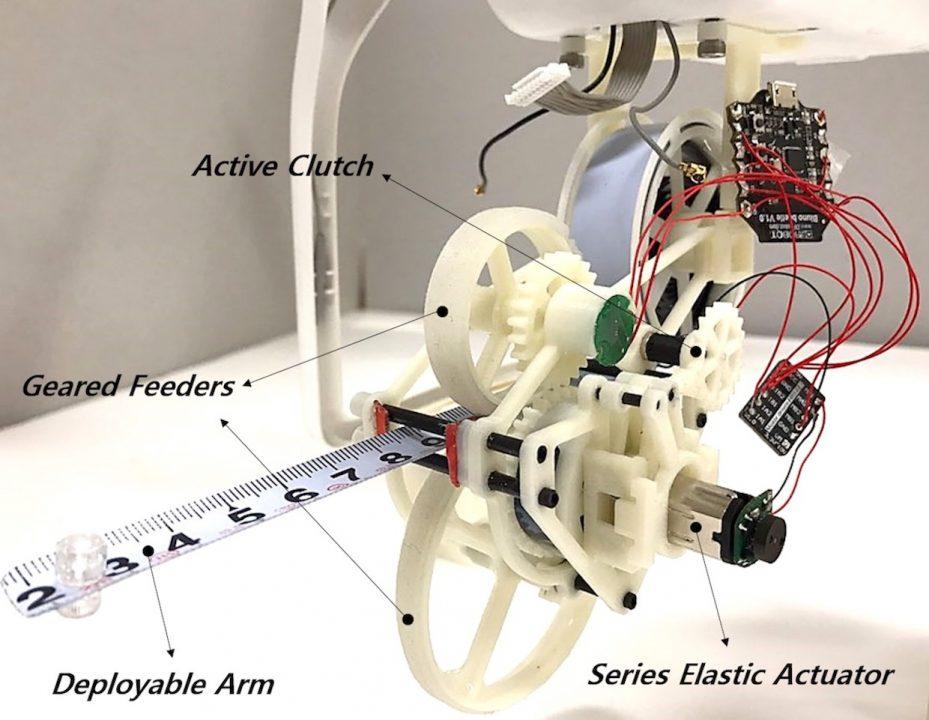

Разработка пригодится домашним помощникам, роботам-доставщикам, а также на складах и в точном земледелии. Следующий шаг — роботы, которые не только видят и слышат, но и ощущают пространство тактильно.