ИИ способен «смотреть» на окружающий мир и учитывать различные его аспекты. Правда, систему можно обмануть, видоизменив привычный для неё предмет — например, наклеив на дорожный знак специальный стикер. Канадские учёные выяснили, что это касается и движущихся объектов.

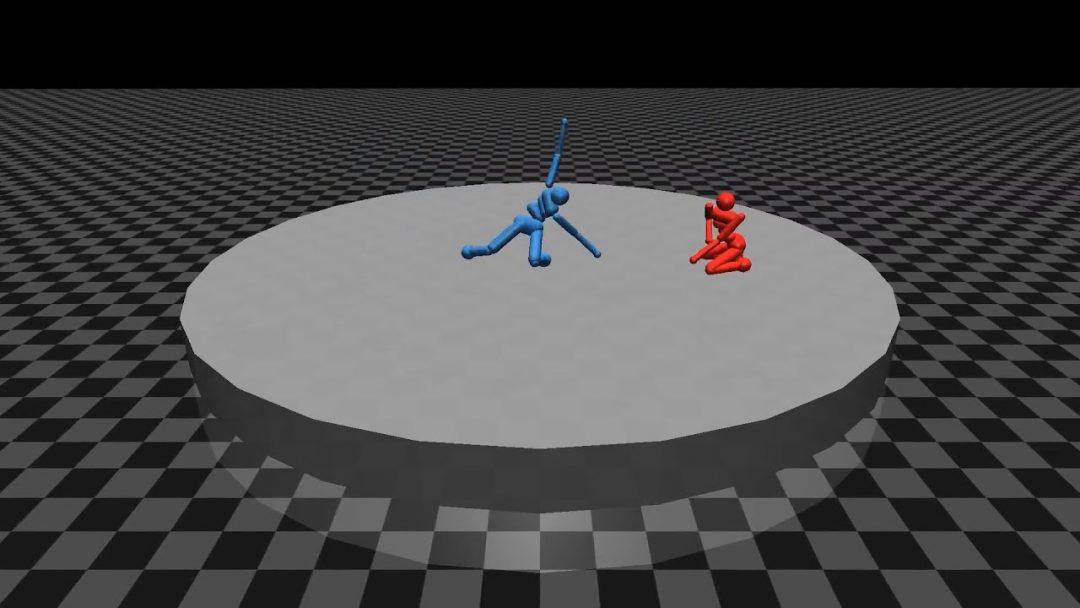

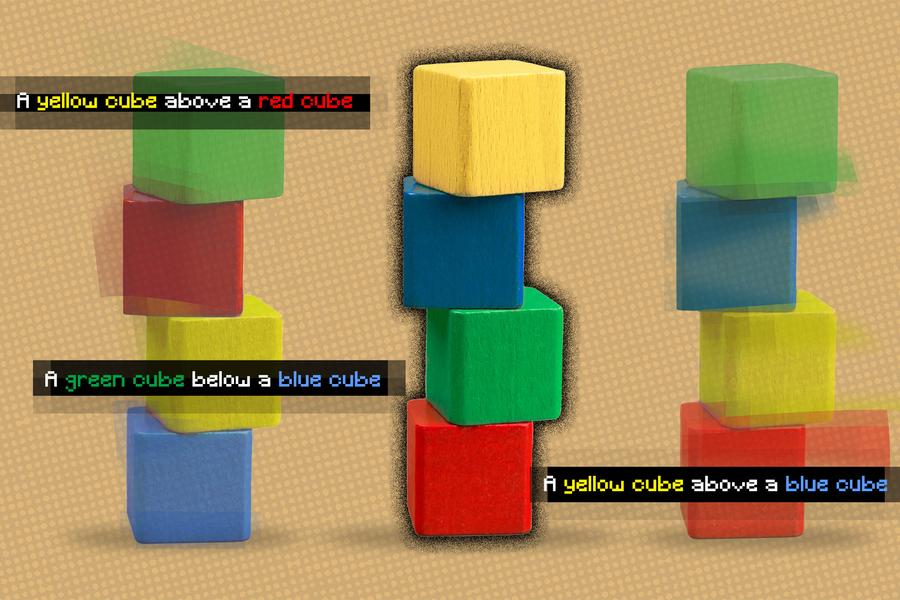

Исследователи провели эксперимент в виртуальном окружении. Они заставили двух ИИ-агентов соревноваться друг с другом в разных видах спорта. Красный агент обучался на действиях синего агента. Всё шло хорошо, пока последний не перестал вести себя привычным образом и не начал совершать непредсказуемые действия. Например, падать, стоя на воротах.

Из-за этого агент-новичок переставал понимать, что происходит, и ломался. А теперь представьте, что какой-нибудь шутник решил выполнить непредсказуемый пируэт на оживлённом шоссе, а проезжающий рядом беспилотный автомобиль впал от этого в ступор.

Если будете обучать собственный ИИ, удосужьтесь подготовить его ко всему. Иначе последствия могут быть плачевными.