😢 Проблема: люди видят объекты вместе с их взаимосвязью в пространстве — не «деревянный стол в точке XYZ», а «деревянный стол справа от серого дивана и слева от белого табурета». Роботы так не умеют.

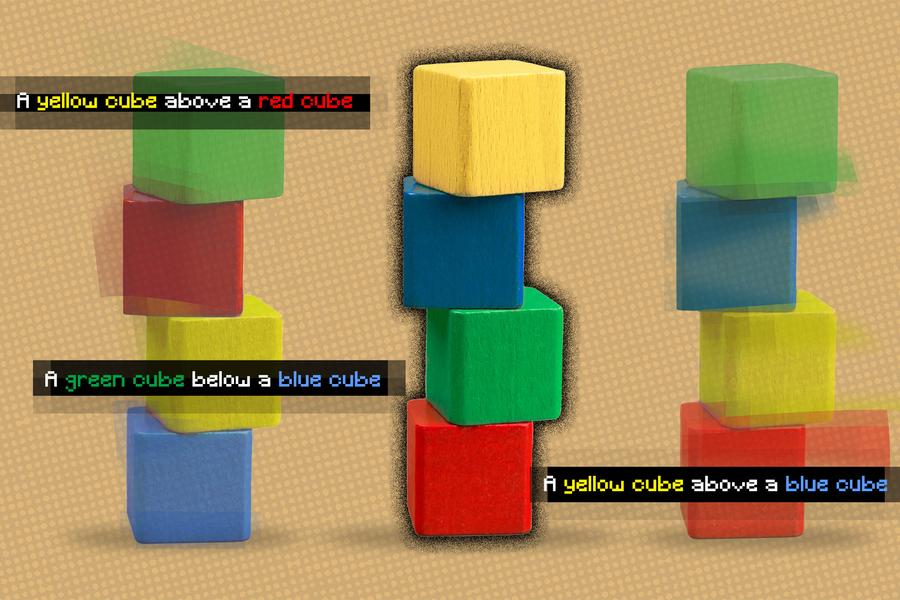

😎 Решение: модель, которая понимает отношения между объектами почти как человек. Она разбивает взаимосвязи из описания на отдельные, моделирует их, а затем создаёт изображение из фрагментов.

Например, моделирует «серый диван слева от деревянного стола» и «белый табурет справа от деревянного стола» и объединяет их. При этом модель может понять, что ей по-разному описали одно и то же, а ещё найти описание, которое соответствует отношениям между объектами на изображении.

По мнению 91% участников эксперимента, новая модель создаёт изображения точнее, чем другие.

🤨 И что? Это большой шаг в решении одной из ключевых проблем компьютерного зрения. Однажды роботы будут понимать команду «дай штуку слева от той штуки».

👥 Кто исследователи Массачусетского технологического института, США.

Источники: news.mit.edu и arxiv.org