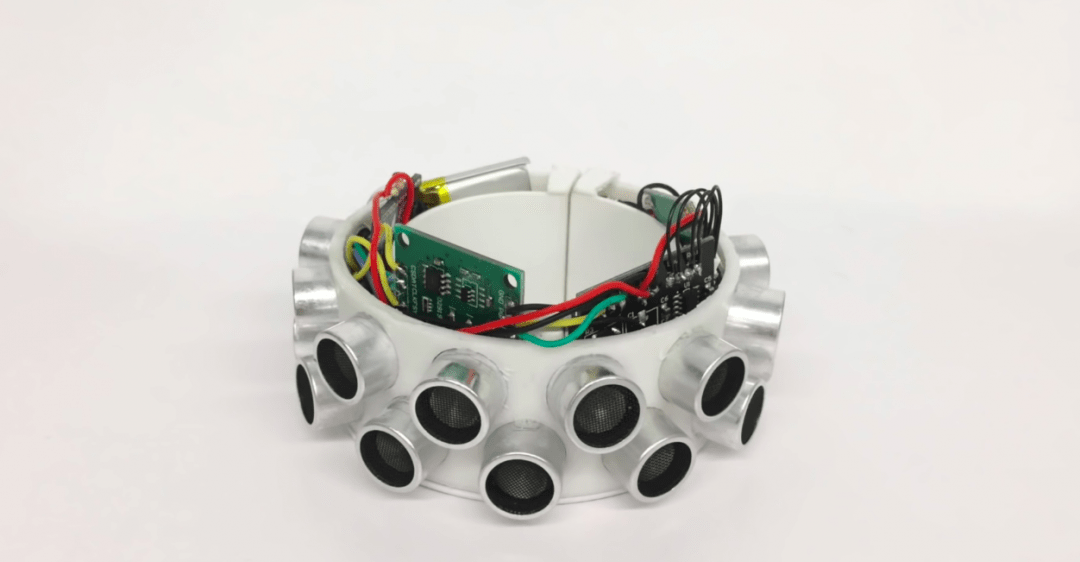

👎 В чём дело: пока технологии недостаточно крутые, чтобы достоверно определять человеческие жесты. Есть технологии узнавания по картинкам, но нужна чёткая картинка. Есть технологии на основе датчиков изгиба, но они не слишком точные.

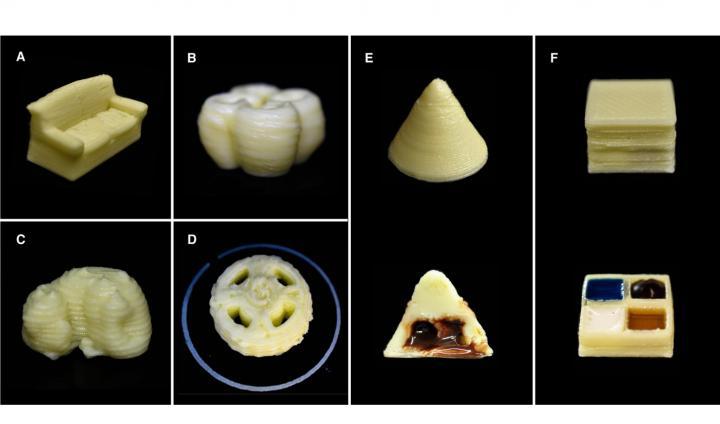

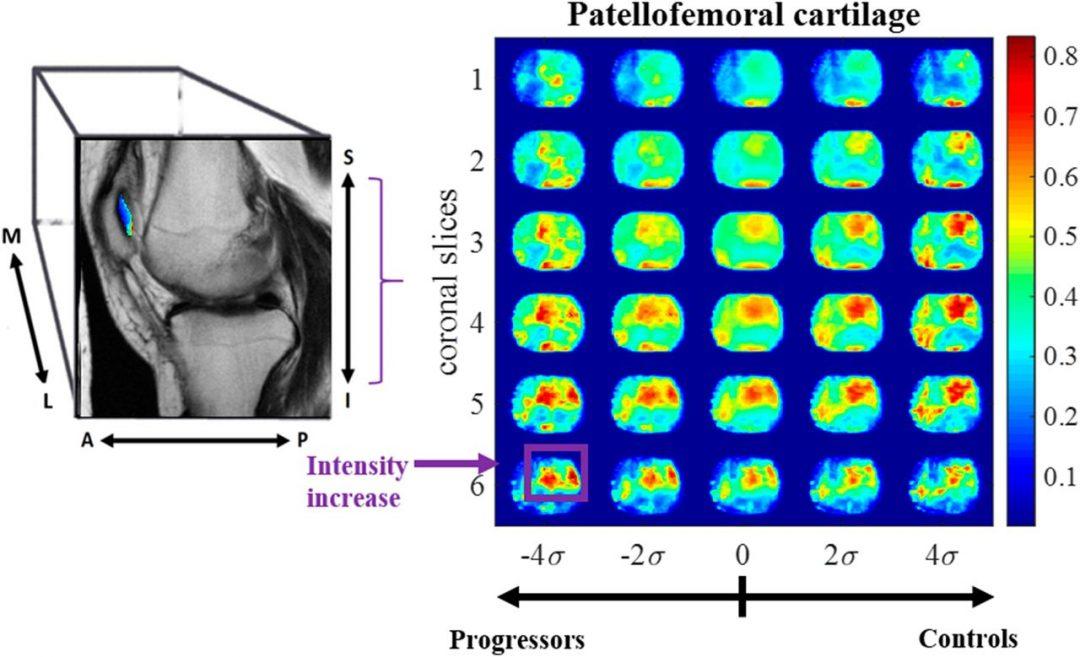

😳 Что: учёные придумали гибридную модель распознавания жестов. Она одновременно смотрит и на картинку, и на данные с датчиков изгиба — и обучается как бы сразу с двух сторон. Такого ещё не делали.

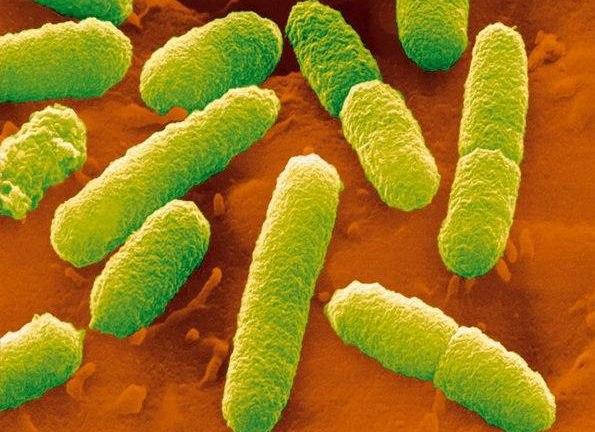

🤔 Как работает: говорят, что работает как человеческий мозг — именно так он обрабатывает мультисенсорную информацию. Это вдохновило учёных использовать визуальный и сенсорный поток данных одновременно, в итоге модель обучилась точнее.

👥 Кто: команды учёных из Наньянского технологического университета и Технологического университета Сиднея.

👉 Почитать

Источник: Tech Xplore

![[Глядите] GRID Compass — ноутбук НАСА, который летал в космос](https://thecode.media/wp-content/uploads/2020/06/MzYzMjg3MQ-960x720.jpeg)