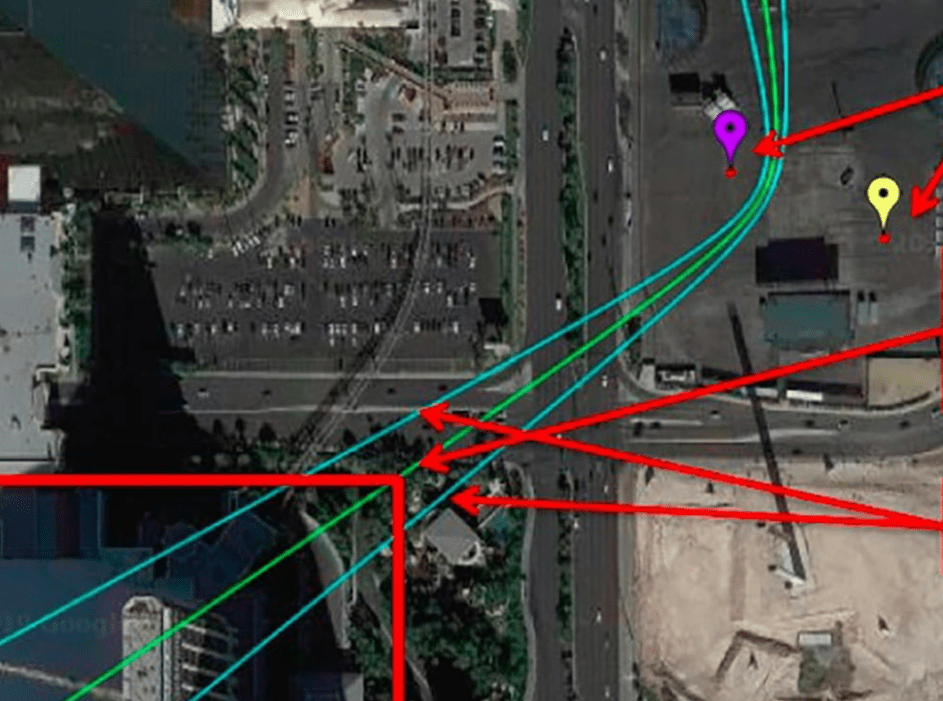

👉 Ситуация: существуют системы прогнозирования, которые используются в полиции. Система на базе нейроночек изучает исторические данные по преступности в городе и показывает потенциально криминогенные зоны в будущем. Вроде как предсказывает преступления на основе больших данных.

😢 Проблема: эти системы оказались очень неточными и даже вредными, потому что обучались на «грязных» данных. «Грязные» — это те, которые получены нечестным путём: например, полицейские были предвзяты, брали взятки, выбивали показания и всё такое.

🧐 Как узнали: изучили 13 полицейских органов США, за которыми числятся обвинения в коррупции, нарушениях и дискриминации. Во всех этих органах использовались системы прогнозирования на базе ИИ. В 9 из 13 случаев стало очевидно, что если данные «грязные», то и предсказания такие. Проблемы с коррупцией, жестокостью, предвзятостью и прочими полицейскими грехами — всё это воспроизводится в моделях ИИ, поэтому не имеет большой ценности для полиции. А то и вредит.

🤔 И что: ничего. Пока не придумали, что с этим делать. Другое исследование показывает, что ИИ более эффективно вычисляет потенциальных рецидивистов, так что ничего не понятно.

🧐 Кто выяснил: Институт искусственного интеллекта в Нью-Йоркском университете.

Источник: The Next Web

![[ВОТ, ПОЧИТАЙТЕ] Как создавали симлиш — язык, на котором говорят в The Sims](https://thecode.media/wp-content/uploads/2020/02/photo_2020-02-20-17.26.26.jpeg)