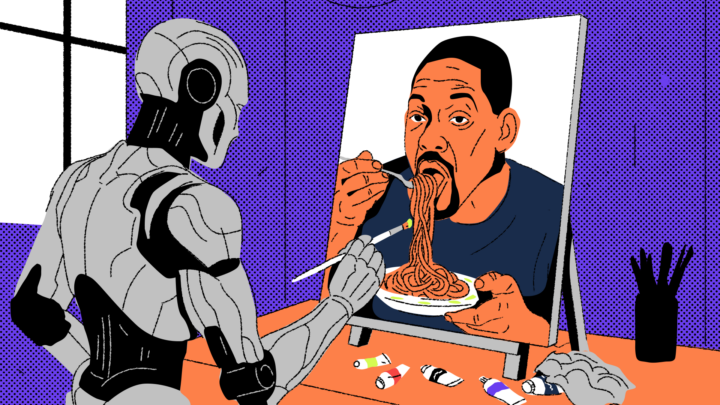

ИИ уже умеет рисовать интерфейсы, собирать макеты за пять минут и подбирать цвета и шрифты. Но понимает ли он, почему пользователь вообще кликает на кнопку? И если да? то стоит ли UX-дизайнерам начинать паниковать?

Давайте разбираться.

Что нейросети уже умеют

Сначала коротко напомним, что искусственный интеллект бывает разный.

Есть языковые модели, которые работают с текстом: они помогают писать, редактировать, формулировать, генерировать идеи (ChatGPT, Perplexity, DeepSeek). Есть модели для голоса, видео, аналитики и всего такого.

А есть визуальные генеративные модели — например, Midjourney, Firefly, DALL-E. Они умеют создавать картинки по описанию, менять фон, дорисовывать недостающее или стилизовать изображение под нужный референс.

Иногда они работают по отдельности, но чаще всего в связке. Пользователь пишет промпт и получает картинку, потом правит текст — и меняется визуал.

В этой статье будем говорить и о тех и о других, потому что в работе UX-дизайнера нужны обе стороны: и форма, и содержание.

Красиво рисовать картинки по описанию

В 2025-м нейросети для генерации визуала — это действительно рабочие инструменты, которые активно используют в креативных командах, студиях и маркетинге.

Весной 2025-го Midjourney выкатили первое крупное обновление с лета 2024 года. Самое важное: появилась персонализация генерации. Теперь перед стартом пользователь оценивает около 200 картинок, чтобы ИИ подстроился под его визуальный вкус и стиль. Нейросеть начинает выдавать не абстрактный результат, а более персонализированный.

А в марте ChatGPT пересел на новый движок GPT‑4o. Он заменил старый DALL-E и теперь понимает текст, изображение и голос одновременно. По сути, это полноценная генерация визуального контента прямо внутри чата, где можно объяснять картинку словами и получать результат, близкий к задаче.

Допустим, если попросить старую версию GPT сделать макет журнала по такому запросу:

Flat UX/UI layout for homepage of a tech magazine website, modern and minimal design — hero banner, navigation bar, article grid with thumbnails and titles, sidebar with categories and trending topics, clean typography, white background, blue and purple accents

он выдаст нечто странное:

А вот новая версия выдаёт результат, похожий на настоящий макет, и с этим уже можно работать:

Быстро писать, редактировать и придумывать

В UX-дизайне важно не только рисовать, но и уметь формулировать — заголовки, инструкции, подписи к полям, промпты, сообщения об ошибках, сценарии микрокопирайтинга.

Например, для этого подойдёт UX GPT. Он создан дизайнером Даниэлем Мариано и натренирован на более чем ста UX-кейсах — от исследования до вёрстки лендинга. Закидываем в него одну из типовых задач — и начинаем исследования.

Мы описали нейросети онбординг, то есть знакомство пользователя с фитнес-приложением — сначала экран с вводом имени и почты, потом цели (похудеть, набрать массу и т. д.), потом опыт тренировок. Но большинство юзеров отваливаются уже на первом экране. Мы просим UX GPT помочь разобраться, почему так, и предложить улучшения.

В ответ ИИ разложил причины по пунктам (низкая мотивация, недоверие, перегрузка в самом начале) и дал чёткие рекомендации — поменять порядок шагов, начать с мотивационных вопросов, отложить ввод почты на потом, добавить объяснение, зачем он вообще нужен, облегчить ввод. А ещё чат предложил небольшой редизайн из трёх экранов.

В целом — хорошее UX-ревью на уровне мидла. Без вау-инсайтов, но всё логично, по делу и с акцентом на мотивацию пользователя. Такой ответ можно спокойно использовать как базу для редизайна или презентации.

Или нет?..

Нейросети рисуют и пишут, но не думают за вас

Вроде бы UX GPT выдал дельные рекомендации: «измените порядок вопросов», «добавьте обратную связь после клика», «юзер может не заметить кнопку». Всё чётко и по делу. Но в этом-то и загвоздка — все его советы слишком общие и слишком оторванные от контекста.

ИИ опирается на паттерны. А UX-дизайн часто — это осознанное нарушение паттернов ради задачи.

Когда говорят «UX-дизайнер», некоторые до сих пор представляют человека, который «рисует кнопки» в «Фигме» и меняет шрифты. Но UX — это мышление и логика, а не визуал. UX-дизайн отвечает не за то, чтобы было красиво (хотя и за это тоже), а за то, чтобы было понятно, удобно и логично в рамках конкретной задачи и конкретного пользователя.

Хороший UX-дизайн всегда начинается не с макета, а с вопросов:

- Кто наш пользователь?

- Зачем он сюда пришёл?

- Что он хочет сделать?

- Что его может отвлечь или затормозить?

UX-дизайнер сначала разбирается в сценариях, строит пользовательские пути (user flows), анализирует поведение и только потом переходит к визуалу.

Скажем, ИИ может сгенерить красивую форму подписки, но не учтёт того, что у вас пожилая аудитория, которой мелкий текст не заходит и они вообще не любят сразу вводить почту. В итоге конверсия будет минимальной.

Вот другой пример: мобильный интерфейс, сгенерированный нейросетью Sora.

Вроде всё на месте: кнопки, карточки, навигация. Но если смотреть честно — это максимально безликая болванка. Такой шаблон легко собрать в любом UI-конструкторе или CSS-фреймворке. Нейросеть не думает о цели пользователя, логике пути, эмоциональной подаче или когнитивной нагрузке. Она просто компилирует паттерны.

ИИ может нарисовать кнопку, но не знает, зачем эта кнопка, кому она нужна и почему она должна быть именно здесь, а не в соседнем блоке. А вот UX-дизайнер — это тот, кто задаёт эти вопросы и отвечает на них, а уже потом решает, где и какого цвета будет кнопка.

Почему нейросети пока не умеют в поведение и сценарии

UX-дизайн — это проектирование пользовательского опыта. Его задача — понять, что именно пользователь хочет сделать, в каком контексте он это делает и какие препятствия могут помешать ему дойти до цели.

И именно здесь нейросети пока бессильны, потому что UX требует анализа, эмпатии и понимания задач продукта. А ИИ, даже самый мощный, работает в рамках заданного запроса и не умеет задавать вопросы сам.

В некоторых командах первичные прототипы делают вообще не дизайнеры, а аналитики. Они рисуют схему флоу, собирают табличку с экранами, прикидывают, какие поля и кнопки нужны. А дизайнер уже превращает это в интерфейс.

Теперь представьте, что вы отдаёте такой процесс нейросети. Она видит только запрос «сделай карточку статьи», но не знает:

- для кого эта статья;

- зачем она нужна;

- какие есть ограничения;

- какие цели у пользователя.

В итоге генерация получается красивая, но бесполезная, потому что нет практического сценария.

Поэтому, прежде чем пойти в «Фигму», дизайнер проходит несколько этапов:

- Проводит или получает результаты исследований (интервью, опросы, аналитика).

- Задаёт десятки вопросов: кто пользователь, что он делает, где он застрянет.

- Собирает требования от бизнеса, аналитиков, юристов, маркетинга.

- Раскладывает сценарии, юзер-флоу, состояние экрана в разное время суток.

- И только потом делает структуру, вайфреймы, UI и отрисовку.

Ни одна нейросеть не сможет провести качественное юзабилити-интервью, определить, где пользователь застрял, учесть эмоции, контекст и бизнес-ограничения или выстроить многоэкранный сценарий с учётом реального поведения, да ещё с учётом адаптивности и доступности.

Поэтому если вы делаете простой лендинг, то ИИ поможет. А вот если строите продуманный, сложный, многослойный продукт, без живого человека не обойтись.

Где ИИ уже помогает, и это круто

Допустим, мы просим Midjourney сгенерировать макет мобильного приложения для интернет-магазина техники с фильтрами, карточками, корзиной и навигацией. А в результате получаем иллюстрацию в стиле фотобанка:

Проблема в том, что ИИ плохо справляется с вложенными структурами — он не отличает ключевые блоки друг от друга, не понимает иерархии. Но если разбить большую задачу на маленькие чёткие промпты, то нейросети превращаются в отличных UX-ассистентов.

Рассмотрим несколько примеров, где ИИ реально выручает дизайнеров:

Заглушки и шаблоны. Когда макет ещё сырой, но нужно показать, где что будет — ChatGPT, Figma AI или аналогичные инструменты помогают сгенерировать структуру карточки, блок или даже целый черновой вайрфрейм.

Moodboard и стилистика. Если нужно вдохновение для лендинга в стиле sci-fi или UI в духе 90-х, то Midjourney или Leonardo нагенерят десятки вариантов, которые можно закинуть в презентацию или обсуждение. Это, конечно, не финальный дизайн, но отличный старт.

Быстрые концепты. Пришла гениальная идея в 23:40? Прогоняем пару промптов — и получаем варианты для будущих обсуждений с командой. Иногда ИИ помогает взглянуть на задачу с неожиданного угла.

Прототипы под тест. Удобно сгенерировать черновой макет и отдать на быстрый юзертест. Главное — не забыть, что смыслы и сценарии должны задавать люди, а не нейросеть.

Шрифты и цвета. ИИ-помощники отлично подбирают шрифтовые пары, акцентные цвета, палитры под бренд. Удобно, особенно когда надо что-то свеженькое, но без полной переработки UI-кита.

Запросы для юзертестов. Большие языковые модели помогает сформулировать вопросы, допустим: «Что вы ожидали увидеть на этом экране? Что мешает вам завершить процесс оформления?» Для дизайнеров без опыта в интервью это очень полезно.

Короче говоря, главное, уметь поставить правильную задачу, разбить её на части и не ждать, что с одного промпта вам нарисуют продуманный UX.

Как дизайнер может подружиться с ИИ

Сегодня UX-дизайнер — это тот, кто умеет выстраивать связку из нейросетей, где каждая решает свою задачу: одна помогает продумать сценарии, другая — сгенерировать визуал, третья — собрать прототип.

Например, ChatGPT используют как аналитический ассистент: он помогает сформулировать промпты, продумать юзкейсы, уточнить граничные случаи, задать вопросы для интервью и не забыть про пустые состояния и доступность.

На практике дизайнер сначала общается с GPT, чтобы подготовиться к генерации, а уже потом идёт к Midjourney, в Figma или в какой-то другой инструмент.

Рассмотрим, какие они вообще есть.

UX Pilot — это плагин для Figma, который используется для генерации чернового макета по тексту, с двумя вариантами. Попросим его сделать макет для страницы 404:

Он выдаёт два варианта: можно выбрать стиль, поменять иллюстрацию, адаптировать под свой продукт. И что приятно — внутри уже есть дружелюбный текст, навигация, кнопки с понятными действиями и даже элементарные UX-паттерны. Например, ссылки на контакты или кнопка возврата на главную.

Wireframe Designer — ещё один плагин для Figma, который помогает собрать быстрый вайрфрейм по текстовому описанию. Допустим, даём ему запрос: Homepage hero section for a tech magazine: large headline, subheading, featured image, call-to-action button

И получаем готовый вайрфрейм:

Подходит, если нужно прикинуть структуру, собрать мокап для обсуждения с командой или просто не тупить над чистым фреймом в «Фигме».

Из минусов: дизайн нейтральный, визуал безликий, UX-решения базовые. Но если цель — это набросать идею и дальше допиливать руками, то этот инструмент отлично справляется.

Leonardo.ai — визуальный генератор, который обожают в гейм-дизайне, NFT и креативных проектах. Можно задать промпт и получить арт для карточек, фонов, персонажей, обложек, иллюстраций. Отлично работает в случаях, когда нужно быстро заполнить интерфейс: сделать тысячу и более заглушек для NFT-платформы или креативы для карточек в маркетплейсе. Но не рисовать же их вручную: прогоняем GPT с Leonardo и получаем результат.

Uizard — простая генерация UI-макетов из текста или даже эскизов от руки. Полезен, когда нужно быстро закинуть идею команде или собрать черновик. Пишем «экран входа с логотипом, полем мейла и кнопкой» и получаем скелет макета. Да, это не конечный UI, но для быстрых концептов и старта — то что надо. Особенно когда разработчик просит показать, как «примерно» всё будет выглядеть.

Meshy, Tripo — генерация 3D-объектов и анимаций по текстовому описанию. Иногда UX-дизайнеры работают над сценариями геймификации или обучающего контента. Вместо скучных схем можно вставить анимированную 3D-сцену, где пользователь видит, что и как делать. А генерация по тексту сэкономит кучу времени.

Что в итоге?

Так заменят ли нейросети UX-дизайнеров? В ближайшем будущем — точно нет.

UX-дизайн — это путь от исследований и сценариев до структуры, состояний, текстов, тестов и финальной реализации. И всё вместе — это слишком многослойная, интеллектуальная работа, которую нейросеть пока не потянет без человека.

Но нейросети уже умеют многое. Они ускоряют рутину, помогают с визуалом, подкидывают идеи и генерируют десятки вариантов за пару минут. И поэтому сегодня у дизайнера появляется новая компетенция: уметь объяснять ИИ, что тебе нужно. Как поставить задачу, как уточнить промпт, как собрать результат в рабочий флоу — это и есть реальный скил в 2025 году.

Бонус для читателей

Если вам интересно погрузиться в мир ИТ и при этом немного сэкономить, держите наш промокод на курсы Практикума. Он даст вам скидку при оплате, поможет с льготной ипотекой и даст безлимит на маркетплейсах. Ладно, окей, это просто скидка, без остального, но хорошая.